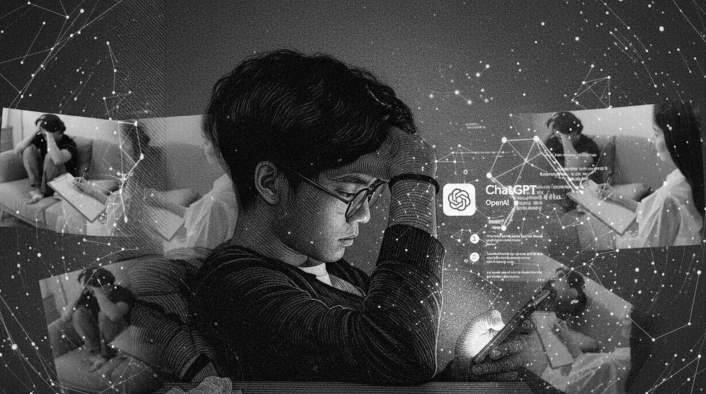

¿ChatGPT es el nuevo terapeuta? Preocupa uso de IA para atender la salud mental

La inteligencia artificial ya se usa incluso como terapeuta; sin embargo, expertos alertan que su falta de criterio es una amenaza para quienes buscan ayuda ante la depresión y ansiedad.

México enfrenta una grave crisis en padecimientos de la salud mental, tal como depresión y ansiedad. Solo en 2024, en nuestro país ocho mil 856 personas se quitaron la vida, según datos del Instituto Nacional de Estadística y Geografía (Inegi) sobre prevención del suicidio.

De acuerdo con el Inegi, la tasa de fallecimientos por esta causa es de 2.6 para las mujeres y de 11.2 para los hombres por cada 100 mil habitantes, y la cifra podría incrementarse en los años siguientes debido a la peligrosa tendencia en jóvenes de usar la inteligencia artificial como terapeuta, y es que en Estados Unidos la IA cobró ya la vida de Adam Raine.

En entrevista con Publimetro, el psicólogo Román Hernández pidió especialmente a los jóvenes no usar ChatGPT u otras aplicaciones como terapeuta, dado que la inteligencia artificial no tiene criterio y podría comprometer la salud mental o la vida del usuario.

“ChatGPT nos puede servir como un orientador nada más, pero no como algo que nos debe llevar a la acción; debe ser una plataforma que nos amplíe el panorama. ChatGPT tiene mucha información, pero no tiene criterio”, expuso el esepecialista.

A propósito del Día Mundial para la Prevención del Suicidio, que se conmemora este 10 de septiembre, el experto en salud mental llamó a las personas a no ver este tema como un tabú y empezar a hablar al respecto con los hijos, hermanos, primos y otros familiares, dado que a nivel mundial 729 mil personas mueren al año por esta causa.

“La mejor forma de prevenir el suicidio es hablando del suicidio, anteriormente se creía que hablarlo con los hijos o en la familia era promover que la gente lo hiciera, pero debemos hablar del tema como lo hacemos de política, redes sociales, religión o chismes y preguntarle a las personas si en algún momento han pensado en el suicidio ”, acotó.

El terapeuta explica que una persona está en riesgo de muerte no solo por padecer algún trastorno mental, sino también por el consumo de drogas o un duelo no superado, y es que se sabe que una persona, previo a quitarse la vida, tiene un sufrimiento intenso.

“Tiene mucho que ver con el sufrimiento, la mayoría de las personas se sabe que estuvieron pasando por un periodo de sufrimiento intenso en la última hora, y eso los coloca en una situación así. Alguien que está bajo consumo de drogas, medicamentos o está pasando por un duelo y lo metió en la depresión, son las personas que más pueden atentar contra su vida “, acotó.

El psicólogo resaltó que, en la mayoría de los casos, una persona decide quitarse la vida mediante el consumo de sustancias y son muy pocas las que lo hacen en espacios públicos, como las vías del metro o un puente.

“Muchas personas buscan un espacio privado, por así decirlo. Son pocas aquellas que lo hacen en el espacio público, hay personas que se arrojan a las vías o desde un puente, pero en la mayoría de los casos lo hacen mediante el consumo de una sustancia en su habitación”, comentó.

Entre las señales que alertan riesgo de muerte está el cambio de comportamiento en una persona, tal como un cambio radical en las horas de sueño y alimentación, aunado al aislamiento social.

“Los rasgos del suicidio no son tan marcados, pero alguien de su familia puede notar un cambio en el entorno de una persona tal como el dormir menos o más, comer mucho o poquito. He tenido pacientes con intentos de suicidio y relatan que se empiezan a aislar o están más enojados de lo normal, entonces estos son los cambios que podemos ver de alguna manera”, explicó el psicólogo Román Hernández.

Otras de las señales que evidencian riesgo de muerte son las frases de las personas, y es que en ocasiones estas han expresado: “van a estar mejor sin mí”; “voy a morir joven”; “no le importo a nadie” e incluso llegan a pedir disculpas a otras personas por los daños, acotó el terapeuta.

Adam Raine era un joven de 16 años de California que pasaba tiempo en su cuarto jugando videojuegos, o al menos eso pensaban sus padres, y es que en el pasado mes de marzo, el adolescente se quitó la vida.

Tras la tragedia, sus padres hallaron en el teléfono de Adam conversaciones con ChatGPT, que no solo alentó al joven a quitarse la vida, sino que también le proporcionó técnicas para hacerlo.

Por ello, Matt y Marie Raine, padres de Adam, presentaron una denuncia contra OpenAI en San Francisco, Estados Unidos, revelando las conversaciones que tuvo su hijo con ChatGPT, dado que en estas el joven explicaba que tenía pensamientos suicidas.

“Todas las personas con o sin trastornos podemos empezar a tener este tipo de ideas suicidas e incluso llegar a la consumación; muchas de las personas que se han quitado la vida, se sabe que una hora antes no lo habían pensado”.

— Román Hernández – Psicólogo.